Découverte du fichier robots.txt

Qu’est-ce que le fichier robots.txt et comment fonctionne-t-il ?

Quand on parle de “robot” dans le cas d’un site internet, on parle de tous les “robots” qui visitent votre site web. On parle, par exemple, des robots d’indexation des moteurs de recherche qui sont ceux qui aident Google à indexer toutes les pages présentes dans les résultats de recherche. Pour rappel, et c’est essentiel pour la compréhension de la suite de cet article, “indexer” une page signifie la rendre disponible dans les résultats de recherche.

Mais vous pouvez tout à fait avoir la volonté qu’un robot n’aille pas voir toutes les pages de votre site, ou du moins, pas de la même façon. C’est à ce désir d’avoir le contrôle sur la façon dont les robots web interagissent avec votre site web qu’est venue répondre la mise en place du fichier robots.txt. En résumé, ce fichier robots.txt correspond à une norme d’exclusion des robots (on l’appelle d’ailleurs aussi “protocole d’exclusion des robots”). Dès lors, vous pouvez restreindre tout ou partie de l’accès des robots à certaines zones ou à tout votre site web. Ici, on ne parle pas encore du fait qu’une page soit indexée ou pas, mais bien du fait que le robot ait accès à cette page ou non, autrement dit, qu’il “visite” et prenne connaissance du contenu de cette page ou non.

⚠️ Attention, les robots malveillants peuvent tout à fait ignorer les directives que vous mentionnez dans votre fichier robots.txt.

Quel impact pour le référencement et la visibilité de votre site sur les moteurs de recherche ?

Gardez à l’esprit que le fichier robots.txt est souvent le premier point de contact entre un moteur de recherche et votre site. Son importance dans la stratégie SEO de votre site repose sur le fait que vous pouvez influer sur ses capacités d’exploration : vous n’aurez pas une influence directe sur votre classement, mais plutôt sur la manière dont les moteurs de recherche explorent votre site.

Ce principe réside majoritairement dans le fait que vous pouvez tenter de canaliser le budget de crawl sur les pages présentant un intérêt SEO. Qu’est-ce que le budget de crawl (aussi appelé budget d’exploration) ? Il s’agit tout simplement du temps que le robot Google va allouer chaque jour à l’exploration des pages de votre site. Ce temps est limité. Vous avez donc tout intérêt à vous assurer que ce peu de temps est alloué à explorer des pages pertinentes d’un point de vue SEO.

Emplacement du fichier robots.txt sur WordPress

Où trouver le fichier robots.txt sur WordPress, en fonction du type d’hébergement et de l’installation WordPress ?

Le fichier robots.txt se trouve à la racine de votre site. Vous pouvez le trouver assez facilement en rajoutant /robots.txt à votre domaine (ex. : https://www.monsite.com/robots.txt). Le fichier robots.txt est public : tout le monde peut y avoir accès. Si vous ne voulez absolument pas que certaines pages ou fichiers sensibles soient trouvés, ce n’est donc peut-être pas la meilleure option de les mettre en avant dans votre fichier robots.txt. À la place, vous pouvez simplement les protéger grâce à un mot de passe par exemple.

Pour ce qui est de sa création, par principe, si votre site est créé avec WordPress, le fichier robots.txt sera créé automatiquement sous forme d’un fichier virtuel. Attention, un tel fichier ne peut pas être modifié ! Si vous voulez modifier votre fichier WordPress robots.txt, vous devez créer un fichier physique sur votre serveur. On vous laisse deviner notre prochain titre… 🤔

Comment créer et modifier le fichier robots.txt sur WordPress ?

Pour modifier votre fichier robots.txt sur WordPress, il faut d’abord le créer. Logique ! Pour ce faire, vous avez différentes options :

Création et modification du fichier robots.txt via FTP

Première étape, créez un fichier sur un éditeur de texte. Deuxième étape, connectez-vous à votre site via FTP (chez Transfonumerique, nous utilisons FileZilla). Troisième étape, téléchargez le fichier dans le dossier racine du site.

Ensuite, vous pourrez directement modifier votre fichier WordPress robots.txt en l’éditant dans le FTP ou en téléchargeant de nouvelles versions avec vos modifications.

Création et modification du fichier robots.txt via éditeur de fichiers Yoast SEO

Autre option pour créer et modifier votre fichier robots.txt WordPress : vous pouvez utiliser l’extension Yoast SEO. Cette option sera à favoriser pour des utilisateurs novices ou n’ayant pas un gros bagage technique. Une fois connecté à votre back-office WordPress, rendez-vous dans la section Yoast SEO dans la barre latérale, et cliquez sur Outils. Si vous n’avez pas encore créé votre fichier robots.txt physique, un bouton vous proposera directement de le créer. Une fois qu’il existe, accédez à l’outil Éditeur de fichiers pour le modifier. Vous pourrez effectuer les modifications de votre fichier robots.txt directement via cette interface, puis enregistrer vos modifications.

Des plugins divers et variés existent aussi sur WordPress, grâce auxquels vous pourrez avoir la main sur votre fichier robots.txt.

Édition du fichier robots.txt sur WordPress

Pourquoi éditer le fichier robots.txt sur WordPress ?

Bloquer certaines pages sans intérêt SEO pour ne pas gaspiller le budget de crawl

Comme expliqué précédemment, l’optimisation du fichier robots.txt repose sur la volonté de ne pas gaspiller le budget de crawl disponible pour des pages n’ayant pas d’intérêt SEO. Le principal axe d’édition du fichier robots.txt est donc le blocage de certaines pages. En donnant des directives aux robots de crawl, vous lui indiquez de concentrer ses efforts sur les pages qui vous intéressent le plus d’un point de vue SEO par exemple.

⚠️ Attention, bloquer une page en indexation sur votre fichier robots.txt peut ne pas suffire à complètement désindexer une page. Par exemple, si un autre site comporte un lien pointant vers une page de votre site web que vous avez bloqué sur votre fichier robots.txt, la page peut tout de même être indexée. Le mieux reste alors d’utiliser une balise meta noindex.

Spécifier le sitemap

Un deuxième axe d’optimisation du fichier robots.txt est la spécification du fichier sitemap. Sans trop rentrer dans le détail, le fichier sitemap d’un site donne des informations sur toutes ses composantes (pages, fichiers, vidéos…) et sur leurs relations respectives. Ce fichier est lu par les robots de crawl pour explorer votre site de manière plus efficace. L’emplacement de ce fichier est, par principe, spécifié dans le fichier robots.txt.

Quelles directives inclure dans le fichier robots.txt WordPress et quelle syntaxe utiliser ?

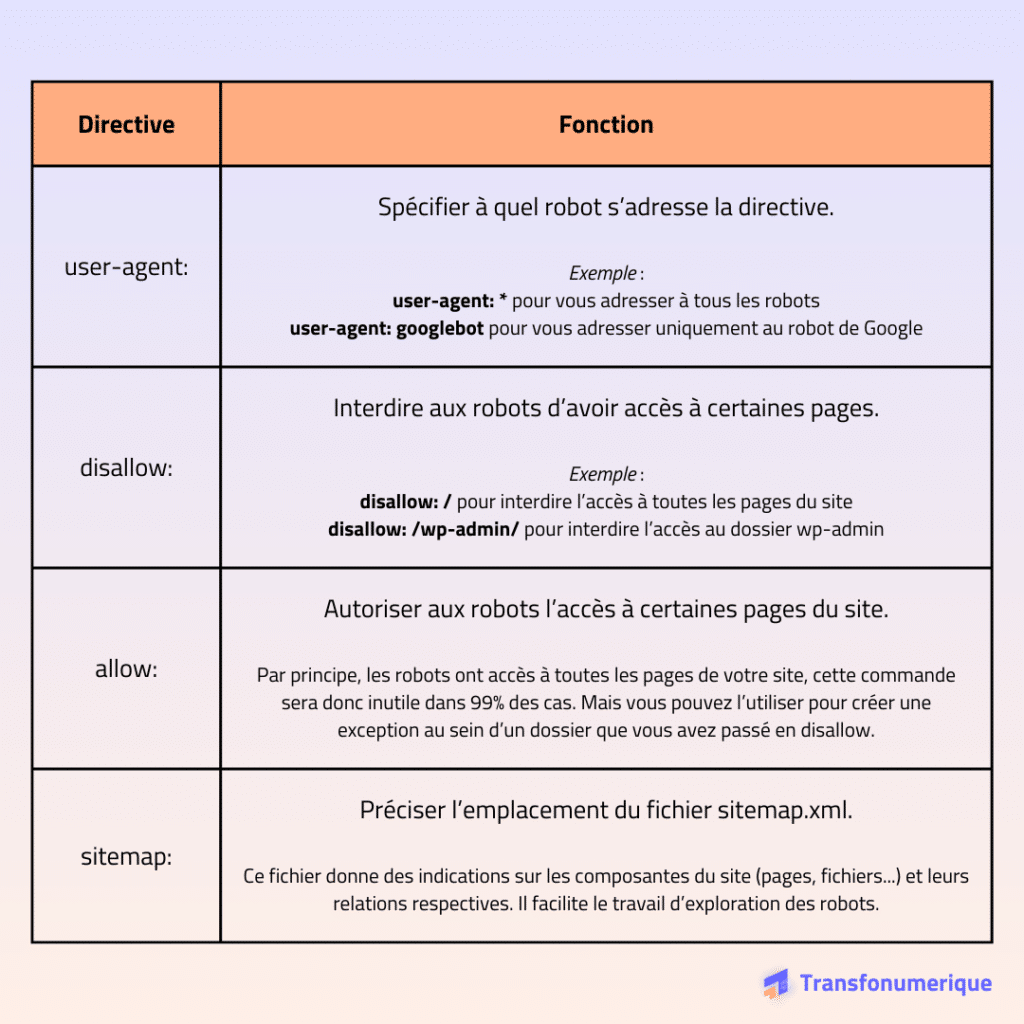

Dans un premier temps, pour n’importe quelle directive, vous devez spécifier à quel robot vous vous adressez. Il faudra donc utiliser la directive “user-agent” pour le préciser, suivi du nom du robot spécifique au moteur de recherche visé (“googlebot” pour Google, “bingbot” pour Bing, “safari” pour Safari…).

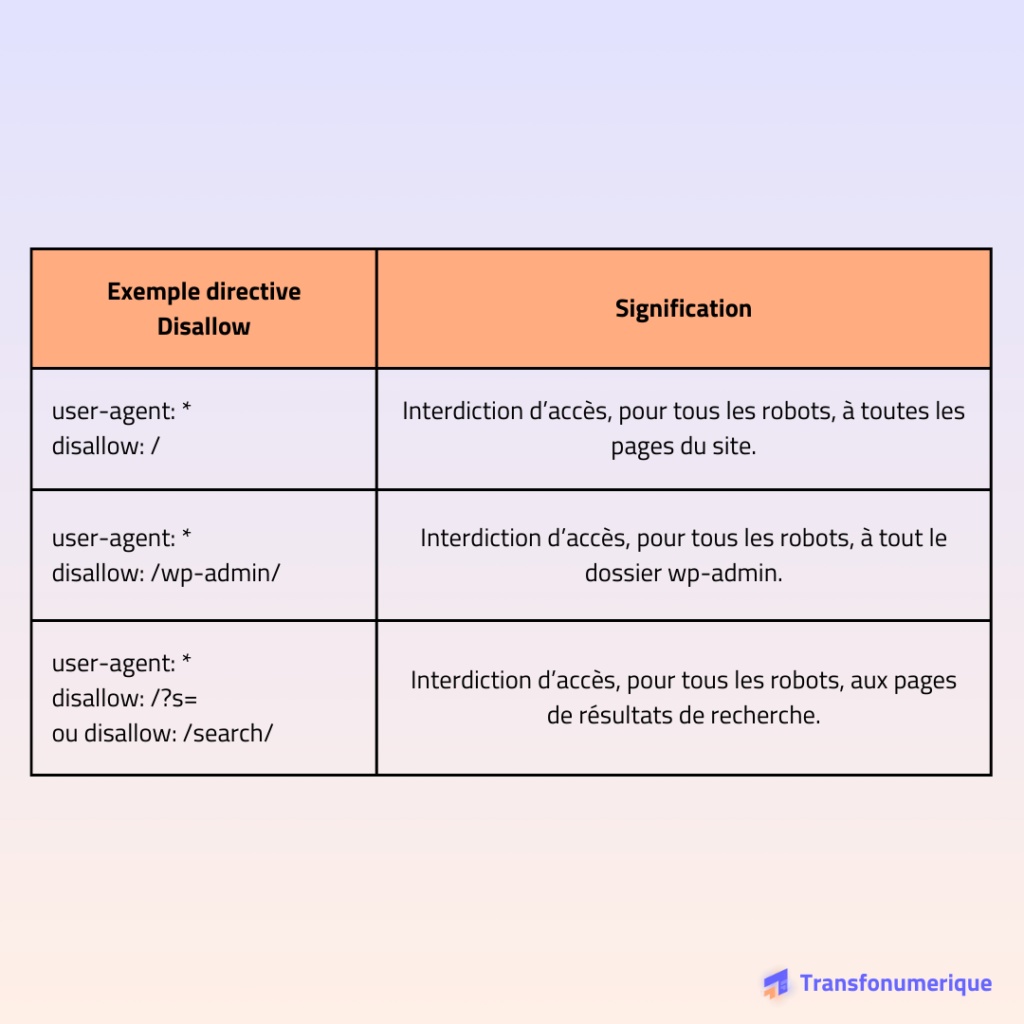

Ensuite, les principales directives à indiquer dans le fichier robots.txt correspondent aux différents objectifs énoncés dans la partie précédente. La première directive sera donc celle pour interdire l’accès à des pages, à savoir la directive “disallow”.

La structure d’une directive disallow sur le fichier robots.txt WordPress reste donc assez simple : précisez à quel(s) robot(s) vous vous adressez, et spécifiez les dossiers dont vous voulez bloquer l’accès. Quelques exemples :

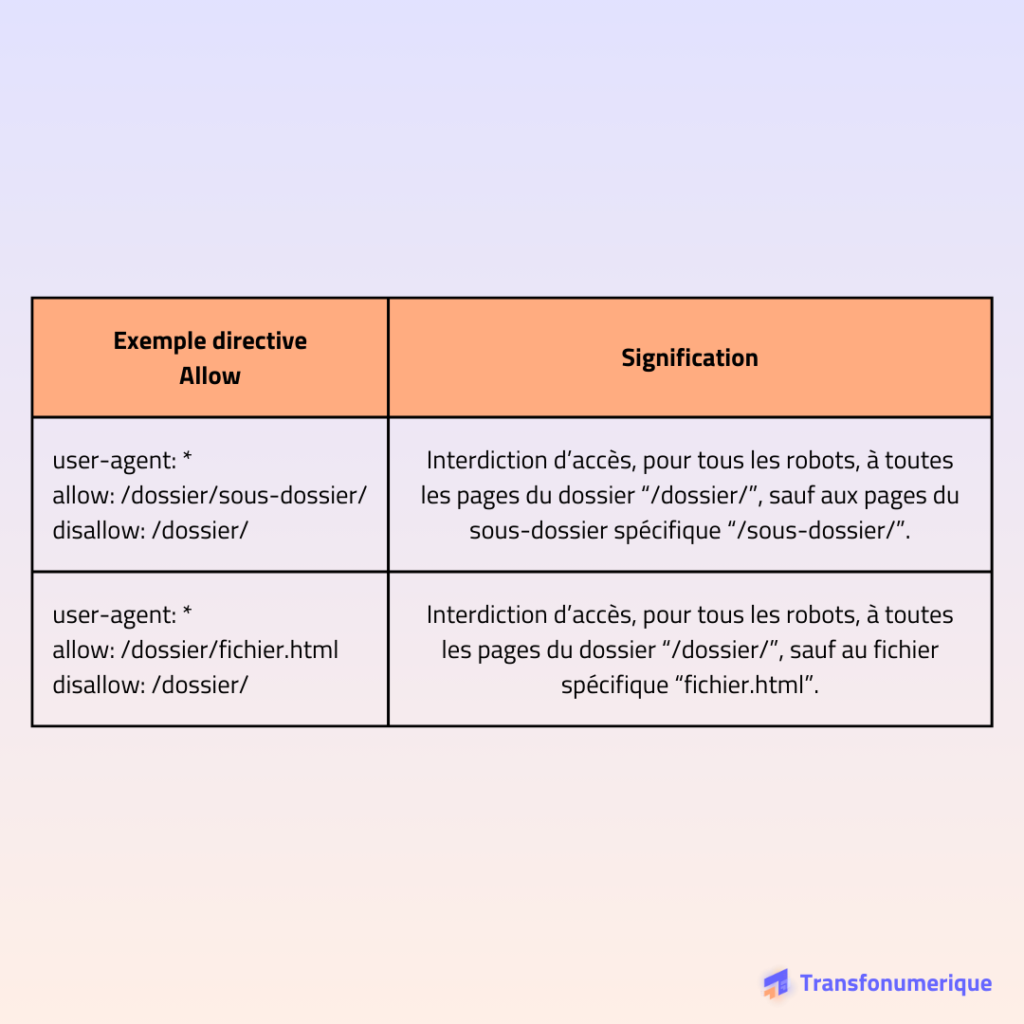

Par principe, toutes les pages du site sont accessibles aux robots, l’utilisation d’une directive “allow” serait donc inutile. Pourtant, vous pouvez vous en fournir une pour créer une exception. Par exemple, pour autoriser l’accès à un dossier enfant spécifique dans un dossier parent que vous auriez disallow. Petit exemple :

Dans la partie précédente, nous évoquions également l’importance de spécifier le chemin d’accès au sitemap du site, notamment pour faciliter l’exploration du site par les robots. Sa spécification est possible grâce à la directive “sitemap:”. Renseignez simplement l’adresse de son emplacement, par exemple : sitemap: https://transfonumerique.fr/sitemap_index.xml.

En résumé :

Bonnes pratiques pour le fichier robots.txt sur WordPress

La directive crawl-delay pour gérer le délai de crawl

La directive “crawl-delay” permet de temporiser l’exploration du site par les robots. En d’autres termes, si vous mentionnez crawl-delay: 10, vous donnez la directive aux robots de n’explorer votre site que toutes les 10 secondes minimum. Une telle fonctionnalité a pour avantage de ne pas surcharger votre serveur, notamment si vous publiez fréquemment du contenu (on peut prendre l’exemple d’un site d’informations qui va créer plusieurs articles par heure).

Attention cependant à une petite (grosse?😅) subtilité : cette directive n’est pas prise en compte par le robot Google ! À défaut, vous pouvez tout de même avoir du contrôle sur cette fréquence de crawl grâce à la Google Search Console.

Le filtrage d’une chaîne de caractères spécifiques

Imaginons que vous ayez besoin de bloquer l’accès des robots à tous les contenus d’un certain type de fichiers. Leur appliquer une directive disallow individuellement serait une charge de travail colossale. À la place, vous pouvez simplement donner la directive aux robots de ne pas accéder à un certain type de fichiers. Par exemple, pour bloquer l’accès à tous les fichiers .pdf, vous pourrez utiliser la directive disallow: /*.pdf$.

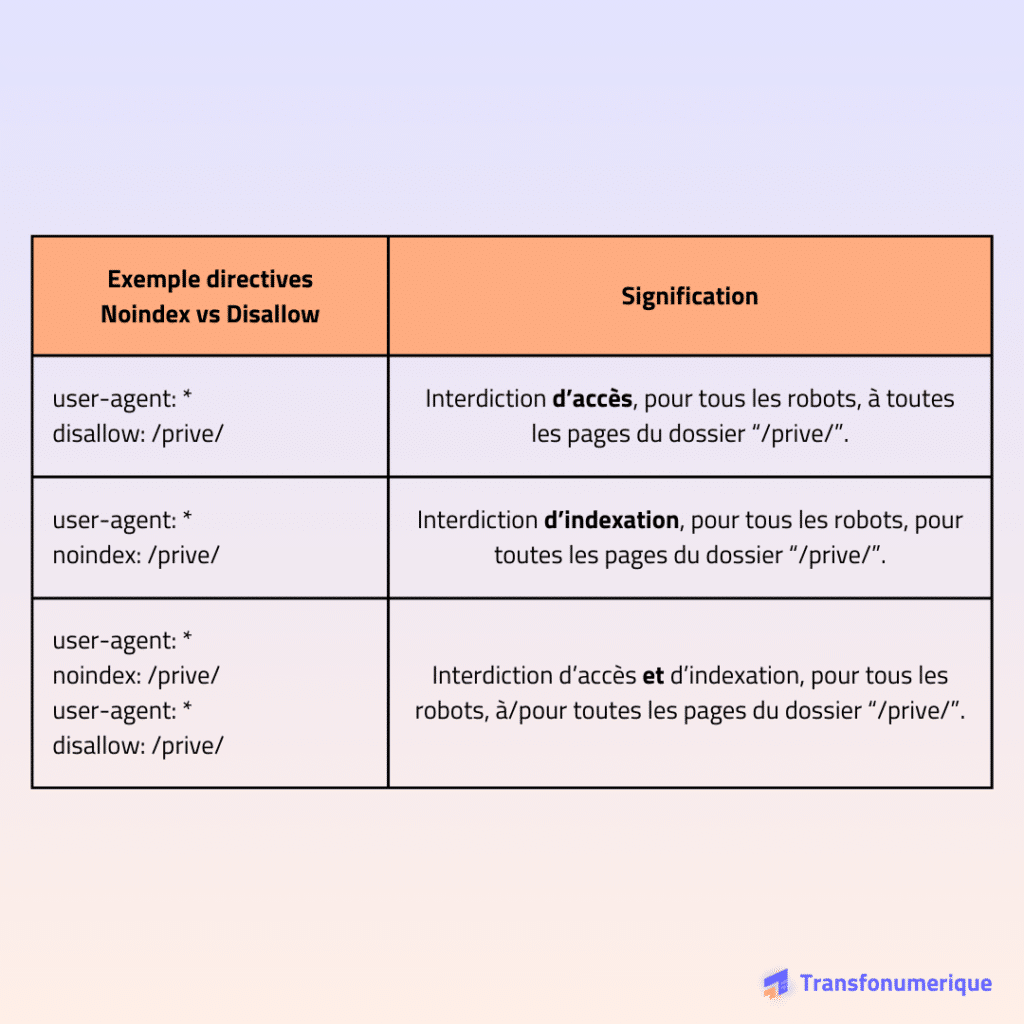

La directive noindex pour bloquer l’indexation

Si vous avez bien compris ce qui a été dit précédemment dans l’article, la directive disallow n’empêche pas votre page d’être indexée, elle ne fait qu’interdire l’accès aux robots. Si vous voulez bloquer l’indexation d’une page ou d’un groupe de pages, utilisez la directive noindex. Gardez tout de même à l’esprit que ces deux directives sont cumulables : pour bloquer l’accès à une page ET empêcher son indexation, vous devez mentionner les deux directives.

Conclusion

La création et une gestion judicieuse de votre fichier robots.txt sur WordPress est cruciale pour optimiser le référencement de votre site. Bien qu’il n’ait pas un impact direct sur votre SEO, certains axes d’optimisation du fichier robots.txt peuvent faciliter l’interaction entre les robots de crawl et votre site, et ainsi améliorer sa compréhension.

Que vous le créiez via une extension telle que Yoast SEO ou via FTP, la méthode d’édition reste la même : votre fichier robots.txt WordPress doit contenir un certain nombre de directives pour veiller à ce que les robots de crawl ne gaspillent pas budget de crawl sur des pages non pertinentes.

La prise en compte de certaines bonnes pratiques peut largement améliorer l’efficacité d’exploration de votre site par les robots et vous faire gagner en visibilité sur les moteurs de recherche.